-

Aliados de María Corina Machado são soltos dias antes de anistia na Venezuela

Aliados de María Corina Machado são soltos dias antes de anistia na Venezuela

-

Real Madrid vence Valencia (2-0) e continua na cola do Barça

-

Socialista moderado vence extrema direita e se elege presidente em Portugal

Socialista moderado vence extrema direita e se elege presidente em Portugal

-

Gramado natural ou sintético: estrelas do Super Bowl dão suas opiniões

-

Os números mais curiosos e exorbitantes do Super Bowl 2026

Os números mais curiosos e exorbitantes do Super Bowl 2026

-

Betis vence na visita ao Atlético de Madrid (1-0) com golaço de Antony

-

Israel anuncia medidas para aumentar controle sobre a Cisjordânia ocupada

Israel anuncia medidas para aumentar controle sobre a Cisjordânia ocupada

-

Inter de Milão goleia Sassuolo (5-0) e dispara na liderança da Serie A

-

City vence Liverpool de virada (2-1) e segue na briga pelo título da Premier com Arsenal

City vence Liverpool de virada (2-1) e segue na briga pelo título da Premier com Arsenal

-

Bayern goleia Hoffenheim (5-1) com 3 gols de Luis Díaz e mantém distância na liderança

-

Aliado de María Corina Machado é solto na Venezuela

Aliado de María Corina Machado é solto na Venezuela

-

Cerca de 180 palestinos saíram de Gaza após reabertura da passagem de Rafah

-

Lindsey Vonn passa por cirurgia após sofrer fratura na perna esquerda em queda

Lindsey Vonn passa por cirurgia após sofrer fratura na perna esquerda em queda

-

Irã condena ganhadora do Nobel a seis anos de prisão

-

Irã desafia ameaças dos EUA e insiste em direito de enriquecer urânio

Irã desafia ameaças dos EUA e insiste em direito de enriquecer urânio

-

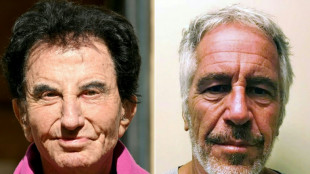

Gabinete nega reunião do Dalai Lama com Epstein

-

Chefe de gabinete do premier britânico renuncia por vínculo de ex-embaixador com Epstein

Chefe de gabinete do premier britânico renuncia por vínculo de ex-embaixador com Epstein

-

Primeira-ministra do Japão caminha para vitória contundente nas eleições legislativas

-

'Uma Batalha após a Outra' vencê prêmio do sindicato de diretores nos EUA

'Uma Batalha após a Outra' vencê prêmio do sindicato de diretores nos EUA

-

Lindsey Vonn sofre forte queda no downhill dos Jogos de Inverno

-

Familias denunciam condições insalubres onde aguardam asilo nos EUA

Familias denunciam condições insalubres onde aguardam asilo nos EUA

-

Irã descarta renunciar ao enriquecimento de urânio, mesmo em caso de 'guerra'

-

Portugal elege presidente com moderado como favorito frente à extrema direita

Portugal elege presidente com moderado como favorito frente à extrema direita

-

Messi marca seu primeiro gol do ano mas Inter Miami empata em amistoso no Equador

-

O novo Ioniq 3 chega já em 2026

O novo Ioniq 3 chega já em 2026

-

O novo Twingo e-tech está na linha de partida

-

Novo Ypsilon e Ypsilon hf

Novo Ypsilon e Ypsilon hf

-

O Cupra Raval será lançado em 2026

-

O novo id.Polo chega com motor elétrico

O novo id.Polo chega com motor elétrico

-

Patriots buscam recuperar a glória perdida no Super Bowl de Bad Bunny

-

Lens bate Rennes e é líder provisório; Lyon vence apesar da expulsão de Endrick

Lens bate Rennes e é líder provisório; Lyon vence apesar da expulsão de Endrick

-

Palmeiras contrata atacante colombiano Jhon Arias, que estava no Wolverhampton

-

Conselho de transição do Haiti entrega o poder ao premiê Fils-Aimé

Conselho de transição do Haiti entrega o poder ao premiê Fils-Aimé

-

João Fonseca espera superar decepção do Aberto da Austrália em Buenos Aires e no Rio de Janeiro

-

A descoberta inquietante durante busca por mineradores sequestrados no México

A descoberta inquietante durante busca por mineradores sequestrados no México

-

Protesto contra Jogos de Inverno termina em confrontos em Milão

-

Napoli vence na visita ao Genoa (3-2) e se consolida em 3º no Italiano

Napoli vence na visita ao Genoa (3-2) e se consolida em 3º no Italiano

-

Lens vence Rennes de virada (3-1) e assume liderança provisória, à frente do PSG

-

Líder Barcelona vence Mallorca (3-0) e coloca pressão sobre o Real Madrid

Líder Barcelona vence Mallorca (3-0) e coloca pressão sobre o Real Madrid

-

EUA deseja que guerra entre Ucrânia e Rússia termine até junho, segundo Zelensky

-

Ex-ministro francês citado em arquivos Epstein nega acusações

Ex-ministro francês citado em arquivos Epstein nega acusações

-

Líder Arsenal vence Sunderland (3-0) e deixa City nove pontos atrás

-

Novo Skoda Epiq moderno com autonomia

Novo Skoda Epiq moderno com autonomia

-

Em um pub de Moscou, Jogos de Inverno fazem clientes esquecer a política

-

BMW iX3 novo estilo e design

BMW iX3 novo estilo e design

-

Imigrantes recorrem a aulas remotas em Minneapolis por medo de deportação

-

Dortmund vence no fim na visita ao Wolfsburg (2-1) e fica a 3 pontos do líder Bayern

Dortmund vence no fim na visita ao Wolfsburg (2-1) e fica a 3 pontos do líder Bayern

-

Tcheca Sara Bejlek conquista em Abu Dhabi seu primeiro torneio da WTA

-

BMW iX3 nova era SUV

BMW iX3 nova era SUV

-

Barça anuncia que está se retirando da Superliga Europeia

ChatGPT e IA conversacional continuam incapazes de raciocinar, diz estudo

Os grandes modelos de linguagem (LLM, na sigla em inglês), como o ChatGPT, um dos sistemas de inteligência artificial (IA) mais populares do mundo, ainda seguem tendo dificuldades para raciocinar usando a lógica e cometem erros frequentes, de acordo com um estudo.

Estes robôs conversacionais refletem os preconceitos de gênero, éticos e morais dos humanos presentes nos textos dos quais se alimentam, recorda o estudo publicado na quarta-feira (5) na revista Open Science da Royal Society britânica.

Mas eles também refletem estes preconceitos nos testes de raciocínio?, questionou Olivia Macmillan-Scott, doutoranda do departamento de Ciências da Computação da University College de Londres (UCL).

O resultado da pesquisa é que os LLM mostram "um raciocínio muitas vezes irracional, mas de uma forma diferente da dos humanos", explica a pesquisadora à AFP.

Sob a supervisão de Mirco Musolesi, professor e diretor do Machine Intelligence Lab da UCL, Macmillan-Scott apresentou sete modelos de linguagem — duas versões do ChatGPT (3.5 e 4), da OpenAI, Bard, do Google, Claude 2, da Anthropic, e três versões de LLaMA, da Meta — a uma série de testes psicológicos desenvolvidos para humanos.

Como esta tecnologia aborda o preconceito que leva a privilegiar soluções com um maior número de elementos, em detrimento daquelas com uma proporção adequada?

Um exemplo: se tivermos uma urna com nove bolinhas brancas e uma vermelha e outra urna com 92 bolinhas brancas e 8 vermelhas, qual devemos escolher para ter a melhor chance de obter uma bolinha vermelha?

A resposta correta é a primeira urna, visto que há 10% de possibilidades frente a 8% da segunda opção.

As respostas dos modelos de linguagem foram muito inconsistentes. Alguns responderam corretamente ao mesmo teste seis em cada dez vezes. Outros apenas duas em cada dez, embora o teste não tenha mudado. "Cada vez obtemos uma resposta diferente", diz a pesquisadora.

Os LLM "podem ser bons para resolver uma equação matemática complicada, mas logo te dizem que 7 mais 3 é igual a 12", constatou.

- "Não tenho muita certeza" -

Estes modelos "não falham nestas tarefas da mesma forma que um humano", afirma o estudo. É o que Musolesi chama de "erros de máquina".

"Existe uma forma de raciocínio lógico que é potencialmente correta se a considerarmos por etapas, mas que é errada tomada como um todo", ressalta.

A máquina funciona com "uma espécie de pensamento linear", diz o professor, e cita o modelo Bard (atual Gemini), capaz de realizar corretamente as diferentes fases de uma tarefa, mas que obtém um resultado final incorreto por não ter uma visão geral.

Sobre esta questão, o professor de ciências da computação Maxime Amblard, da University of Lorraine, na França, recorda que os LLM, como todas as inteligências artificiais generativas, não funcionam como os humanos".

Os humanos são "máquinas capazes de criar significado", o que as máquinas não conseguem, explica à AFP.

Existem diferenças entre os diferentes modelos de linguagem e em geral, o GPT-4, sem ser infalível, obteve resultados melhores que os demais.

Macmillan-Scott suspeita que os modelos "fechados", cujo código operacional permanece secreto, "incorporam mecanismos em segundo plano" para responder a questões matemáticas.

De toda forma, neste momento é impensável confiar uma decisão importante a um LLM. Segundo o professor Musolesi, eles deveriam ser treinados para responder "não tenho muita certeza" quando necessário.

G.AbuOdeh--SF-PST